随着微信的普及,越来越多的人开始使用微信。微信渐渐从一款单纯的社交软件转变成了一个生活方式,人们的日常沟通需要微信,工作交流也需要微信。微信里的每一个好友,都代表着人们在社会里扮演的不同角色。

今天这篇文章会基于Python对微信好友进行数据分析,这里选择的维度主要有:性别、头像、签名、位置,主要采用图表和词云两种形式来呈现结果,其中,对文本类信息会采用词频分析和情感分析两种方法。常言道:工欲善其事,必先利其器也。在正式开始这篇文章前,简单介绍下本文中使用到的第三方模块:

itchat:微信网页版接口封装Python版本,在本文中用以获取微信好友信息。

jieba:结巴分词的 Python 版本,在本文中用以对文本信息进行分词处理。

matplotlib:Python 中图表绘制模块,在本文中用以绘制柱形图和饼图

snownlp:一个 Python 中的中文分词模块,在本文中用以对文本信息进行情感判断。

PIL:Python 中的图像处理模块,在本文中用以对图片进行处理。

numpy:Python中 的数值计算模块,在本文中配合 wordcloud 模块使用。

wordcloud:Python 中的词云模块,在本文中用以绘制词云图片。

TencentYoutuyun:腾讯优图提供的 Python 版本 SDK ,在本文中用以识别人脸及提取图片标签信息。

以上模块均可通过 pip 安装,关于各个模块使用的详细说明,请自行查阅各自文档。

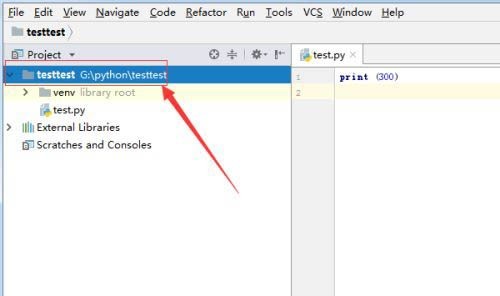

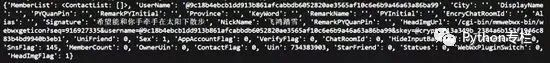

分析微信好友数据的前提是获得好友信息,通过使用 itchat 这个模块,这一切会变得非常简单,我们通过下面两行代码就可以实现:

3. 好友头像分析好友头像,从两个方面来分析,第一,在这些好友头像中,使用人脸头像的好友比重有多大;第二,从这些好友头像中,可以提取出哪些有价值的关键字。这里需要根据HeadImgUrl字段下载头像到本地,然后通过腾讯优图提供的人脸识别相关的API接口,检测头像图片中是否存在人脸以及提取图片中的标签。其中,前者是分类汇总,我们使用饼图来呈现结果;后者是对文本进行分析,我们使用词云来呈现结果。关键代码如下所示:可以注意到,在所有微信好友中,约有接近1/4的微信好友使用了人脸头像, 而有接近3/4的微信好友没有人脸头像,这说明在所有微信好友中对”颜值 “有自信的人,仅仅占到好友总数的25%,或者说75%的微信好友行事风格偏低调为主,不喜欢用人脸头像做微信头像。其次,考虑到腾讯优图并不能真正的识别”人脸”,我们这里对好友头像中的标签再次进行提取,来帮助我们了解微信好友的头像中有哪些关键词,其分析结果如图所示:通过词云,我们可以发现:在微信好友中的签名词云中,出现频率相对较高的关键字有:女孩、树木、房屋、文本、截图、卡通、合影、天空、大海。这说明在我的微信好友中,好友选择的微信头像主要有日常、旅游、风景、截图四个来源。好友选择的微信头像中风格以卡通为主,好友选择的微信头像中常见的要素有天空、大海、房屋、树木。通过观察所有好友头像,我发现在我的微信好友中,使用个人照片作为微信头像的有15人,使用网络图片作为微信头像的有53人,使用动漫图片作为微信头像的有25人,使用合照图片作为微信头像的有3人,使用孩童照片作为微信头像的有5人,使用风景图片作为微信头像的有13人,使用女孩照片作为微信头像的有18人,基本符合图像标签提取的分析结果。4. 好友签名分析好友签名,签名是好友信息中最为丰富的文本信息,按照人类惯用的”贴标签”的方法论,签名可以分析出某一个人在某一段时间里状态,就像人开心了会笑、哀伤了会哭,哭和笑两种标签,分别表明了人开心和哀伤的状态。这里我们对签名做两种处理,第一种是使用结巴分词进行分词后生成词云,目的是了解好友签名中的关键字有哪些,哪一个关键字出现的频率相对较高;第二种是使用SnowNLP分析好友签名中的感情倾向,即好友签名整体上是表现为正面的、负面的还是中立的,各自的比重是多少。这里提取Signature字段即可,其核心代码如下:def analyseSignature(friends):

signatures = ''

emotions = []

pattern = re.compile("1fd.+")

for friend in friends:

signature = friend['Signature']

if(signature != None):

signature = signature.strip().replace('span', '').replace('class', '').replace('emoji', '')

signature = re.sub(r'1f(d.+)','',signature)

if(len(signature)>0):

nlp = SnowNLP(signature)

emotions.append(nlp.sentiments)

signatures += ' '.join(jieba.analyse.extract_tags(signature,5))

with open('signatures.txt','wt',encoding='utf-8') as file:

file.write(signatures)

# Sinature WordCloud

back_coloring = np.array(Image.open('flower.jpg'))

wordcloud = WordCloud(

font_path='simfang.ttf',

background_color="white",

max_words=1200,

mask=back_coloring,

max_font_size=75,

random_state=45,

width=960,

height=720,

margin=15

)

wordcloud.generate(signatures)

plt.imshow(wordcloud)

plt.axis("off")

plt.show()

wordcloud.to_file('signatures.jpg')

# Signature Emotional Judgment

count_good = len(list(filter(lambda x:x>0.66,emotions)))

count_normal = len(list(filter(lambda x:x>=0.33 and x通过词云,我们可以发现:在微信好友的签名信息中,出现频率相对较高的关键词有:努力、长大、美好、快乐、生活、幸福、人生、远方、时光、散步。

通过以下柱状图,我们可以发现:在微信好友的签名信息中,正面积极的情感判断约占到55.56%,中立的情感判断约占到32.10%,负面消极的情感判断约占到12.35%。这个结果和我们通过词云展示的结果基本吻合,这说明在微信好友的签名信息中,约有87.66%的签名信息,传达出来都是一种积极向上的态度。

分析好友位置,主要通过提取Province和City这两个字段。Python中的地图可视化主要通过Basemap模块,这个模块需要从国外网站下载地图信息,使用起来非常的不便。

百度的ECharts在前端使用的比较多,虽然社区里提供了pyecharts项目,可我注意到因为政策的改变,目前Echarts不再支持导出地图的功能,所以地图的定制方面目前依然是一个问题,主流的技术方案是配置全国各省市的JSON数据。

这里我使用的是BDP个人版,这是一个零编程的方案,我们通过Python导出一个CSV文件,然后将其上传到BDP中,通过简单拖拽就可以制作可视化地图,简直不能再简单,这里我们仅仅展示生成CSV部分的代码:

def analyseLocation(friends):

headers = ['NickName','Province','City']

with open('location.csv','w',encoding='utf-8',newline='',) as csvFile:

writer = csv.DictWriter(csvFile, headers)

writer.writeheader()

for friend in friends[1:]:

row = {}

row['NickName'] = friend['NickName']

row['Province'] = friend['Province']

row['City'] = friend['City']

writer.writerow(row)下图是BDP中生成的微信好友地理分布图,可以发现:我的微信好友主要集中在宁夏和陕西两个省份。

这篇文章是我对数据分析的又一次尝试,主要从性别、头像、签名、位置四个维度,对微信好友进行了一次简单的数据分析,主要采用图表和词云两种形式来呈现结果。总而言之一句话,”数据可视化是手段而并非目的”,重要的不是我们在这里做了这些图出来,而是从这些图里反映出来的现象,我们能够得到什么本质上的启示,希望这篇文章能让大家有所启发。